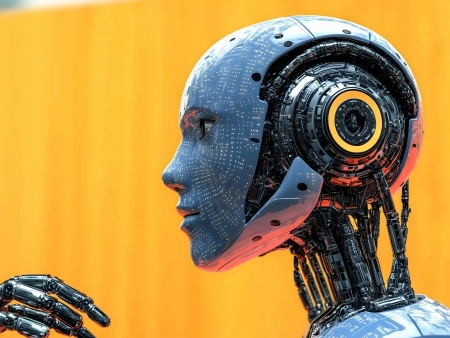

A GPT-4V-hez és a Geminihez hasonlóan az MM1 is a Large Language Model (LLM) architektúrán alapul, és kép-szöveg párok, egymásba illesztett kép-szöveg dokumentumok és csak szöveges adatok keverékén lett betanítva (45% kép-szöveg párok, 45% egymásba illesztett kép-szöveg dokumentumok, 10% csak szöveges adatok). Ez a tréningprogram lehetővé tette, hogy az MM1 a riválisaihoz hasonló képességeket fejlesszen ki, beleértve a képleírást, a kérdések megválaszolását és még az alapvető matematikai problémamegoldást is - közölte a The Decoder.

Az Apple kutatói mélyreható vizsgálatokat végeztek az MM1 teljesítményét leginkább befolyásoló tényezők, például az architektúrális összetevők és a képzési adatok azonosítása érdekében. Felfedezték, hogy a nagy képfelbontás, a képfeldolgozó komponens (az úgynevezett "vizuális kódoló") teljesítménye és a képzési adatok mennyisége különösen fontos. Érdekes módon a kép és a nyelv közötti kapcsolatot kevésbé találták kritikusnak.

A vizuális kódoló feladata a képi információk átalakítása olyan formátumba, amelyet a mesterséges intelligencia rendszer képes feldolgozni. Minél fejlettebb ez a kódoló, annál jobban megérti és értelmezi a képtartalmat az MM1.

A kutatás rávilágít a képzési adatok megfelelő keverékének fontosságára is. A kép-szöveg párok, az egymásba illesztett kép-szöveg adatok és a csak szöveges adatok elengedhetetlenek voltak ahhoz, hogy a bemeneti kérdőívben szereplő korlátozott számú példával erős eredményeket érjünk el. Amikor azonban az MM1-nek a promptban szereplő példák nélkül kellett kimeneteket generálnia, a kép-szöveg párok a képzési adatokban jelentősebb szerepet játszottak.

A kép-szöveg párok vagy kép-felirat párok olyan adatok, amelyekben minden egyes kép közvetlenül párosul egy hozzá tartozó szöveggel. Ez a szöveg általában a kép tartalmának leírása vagy magyarázata. Egy példa erre egy kutya képe a következő felirattal: "Egy barna kutya labdával játszik a parkban". Az ilyen párosított adatokat gyakran használják modellek képzésére olyan feladatokhoz, mint például az automatikus képcímkézés.

Másrészt az átlapolt kép-szöveg adatok olyan adatok, amelyekben a képek és a szöveg vegyes sorrendben jelennek meg, anélkül, hogy minden egyes képet szükségszerűen közvetlenül egy adott szöveghez társítanának. Erre példa lehet egy hírcikk, amely ugyanarra a témára vonatkozó képek és szöveges részek keverékéből áll, de nem feltétlenül 1:1 arányban. Az ilyen adatok általában azt tükrözik, ahogyan a vizuális és szöveges információk gyakran együtt fordulnak elő természetes kontextusokban.

Kimutatták, hogy mindkét adattípus - azaz mind a kép-szöveg párok, mind a vegyes kép-szöveg adatok - keveréke a csak szöveges adatokkal együtt előnyös a multimodális AI modellek képzéséhez, különösen, ha kevés példával jó eredményeket lehet elérni (Few-Shot Learning).

Az MM1 olyan összetettebb esetekben is kiválóan teljesít, mint például a több képből történő következtetés, ahol több képből származó információkat képes kombinálni, hogy komplex kérdésekre válaszoljon, vagy olyan következtetéseket vonjon le, amelyek egyetlen képből nem vonhatók le. Ez segíthet az MM1-nek abban, hogy az emberi érzékeléshez és gondolkodáshoz nagyon hasonlóan megértse és értelmezze a való világot.

AI NEWS: 🍏 Apple introduces MM1, a multimodal AI with an architecture that competes with GPT-4V & Google Gemini

— The Artificially Intelligent Enterprise (@theaienterprise) March 18, 2024

Here's what you need to know:

🧠 MM1's training includes 45% image-text pairs & 45% interleaved documents, fine-tuned to master image description, Q&A, and basic… pic.twitter.com/RpoWUIIAQW